DataDome dévoile les conclusions de son étude Global Bot Security Report 2025. Les résultats de l’étude révèlent une nouvelle réalité : l’IA est désormais la force dominante qui façonne le trafic en ligne, et pourtant, la plupart des entreprises restent exposées et pas prêtes à y faire face. L’analyse à grande échelle menée par DataDome porte sur plus de 17 000 sites web, répartis dans 22 secteurs d’activités, dans le but d’examiner la résilience des entreprises face aux menaces automatisées.

Le trafic généré par l’IA, des robots d’exploration LLM (Large Language Model) aux agents IA, a atteint des niveaux sans précédent. En 2025, le trafic généré par les robots d’exploration et les robots IA a quadruplé parmi la base client de DataDome, représentant désormais plus d’une requête de robot vérifiée sur 10. Ce changement radical signifie que les organisations doivent faire face à une nouvelle réalité dans laquelle le trafic piloté par l’IA n’est plus l’exception mais la norme.

« Les agents IA révolutionnent les interactions en ligne. Ils imitent le comportement humain, génèrent des navigateurs synthétiques, contournent les CAPTCHA et s’adaptent en temps réel. Les défenses traditionnelles, conçues pour repérer les automatisations statiques, s’effondrent face à cette complexité. Les entreprises ne peuvent pas déterminer si le trafic IA qu’elles observent est positif ou négatif, ce qui les expose à la fraude et les prive d’opportunités de créer de la valeur avec ce trafic. Désormais, il est crucial d’avoir une protection adaptative, basée sur l’intention, capable de déchiffrer cette complexité générée par l’IA en temps réel. », souligne Jérôme Segura, vice-président de la recherche chez DataDome.

Retour sur les principales conclusions de l’étude à l’échelle mondiale

- Le trafic IA a explosé : le trafic des robots d’indexation LLM a quadruplé parmi la clientèle de DataDome en 2025, passant de 2,6 % du trafic vérifié des robots en janvier à plus de 10,1 % en août. DataDome a détecté près de 1,7 milliard de requêtes provenant des robots d’indexation OpenAI en un seul mois. Ces robots d’indexation extraient des quantités massives de contenu web, généralement sans consentement ni surveillance, épuisent les ressources du serveur et exposent les données propriétaires.

- Les entreprises tentent de résister, mais sans succès : 88,9 % des domaines interdisent GPTBot dans leurs fichiers robots.txt, une mesure qui offre peu de protection réelle. Les robots d’indexation et les navigateurs basés sur l’IA ignorent ces directives, rendant ces stratégies de blocage plutôt obsolètes. Sans une application active au-delà du fichier robots.txt, les entreprises risquent d’exposer leur contenu, leurs données et leur infrastructure à la prochaine génération de menaces automatisées.

- Les défenses traditionnelles s’effondrent rapidement : seulement 2,8 % des sites web analysés par DataDome étaient entièrement protégés en 2025, contre 8,4 % en 2024. La plupart des entreprises ne parviennent toujours pas à stopper les robots, même les plus basiques, et encore moins ceux pilotés par l’IA qui adaptent leur identité et leur comportement.

- Les bots IA atteignent les terminaux à forte valeur ajoutée des sites : contrairement aux automatisations plus anciennes, le trafic piloté par l’IA ne se limite pas au scraping. En 2025, 64 % du trafic des bots IA a réussi à atteindre les formulaires, 23 % les pages de connexion et 5 % les flux de paiement, créant ainsi de nouveaux vecteurs de fraude, de prise de contrôle de comptes et de risques de conformité.

- Le trafic IA est une arme à double tranchant pour les entreprises : bien qu’il soit en grande partie malveillant, les requêtes pilotées par l’IA représentent également de nouveaux cas d’utilisation légitimes. Sans la capacité de classer les intentions, les entreprises risquent de bloquer l’innovation ou d’ouvrir la voie à des abus.

- Les secteurs à haut risque restent sous-protégés : parmi les secteurs analysés, les secteurs public, associatif et des télécommunications sont les moins bien protégés. Parallèlement, les secteurs du voyage et de l’hôtellerie, des jeux d’argent et de l’immobilier affichent les taux combinés de protection complète et partielle les plus élevés. Pour autant, même parmi les secteurs les plus performants, la protection dite complète est rare, et une protection partielle seule ne suffit pas à stopper les bots les plus sophistiqués.

- Parmi les sites web les plus visités : seuls 2 % des domaines enregistrant plus de 30 millions de visites mensuelles étaient entièrement protégés. Même pour les entreprises de plus de 10 001 employés, seulement 2,2 % bénéficient d’une protection totale et 61 % n’étaient absolument pas protégées.

- Les bots avancés échappent à la plupart des défenses : les bots anti-empreintes digitales n’étaient bloqués que par environ 7 % des sites, ce qui rend la plupart des entreprises vulnérables aux piratages de comptes, aux tentatives de fichage et aux attaques de scraping avancées. Les faux bots Chrome et Curl n’ont été détectés que dans 21 % des cas.

- La faiblesse des défenses contre les bots est une constante mondiale : l’absence de variation régionale permet aux attaquants de réutiliser les mêmes outils sur tous les marchés, réduisant ainsi les coûts et augmentant l’évolutivité des campagnes mondiales de cyberfraude.

– L’Amérique du Nord et l’Europe présentent des tendances similaires, avec plus de 60 % des sites web dépourvus de protection contre les robots.

– L’Amérique latine affiche la plus forte proportion de sites web protégés, avec seulement 3,5 % des sites analysés qui étaient entièrement protégés et 38,5 % partiellement protégés, laissant près de 6 domaines sur 10 complètement exposés.

– L’Asie-Pacifique accuse un retard supplémentaire, avec seulement 1,6 % de sites entièrement protégés.

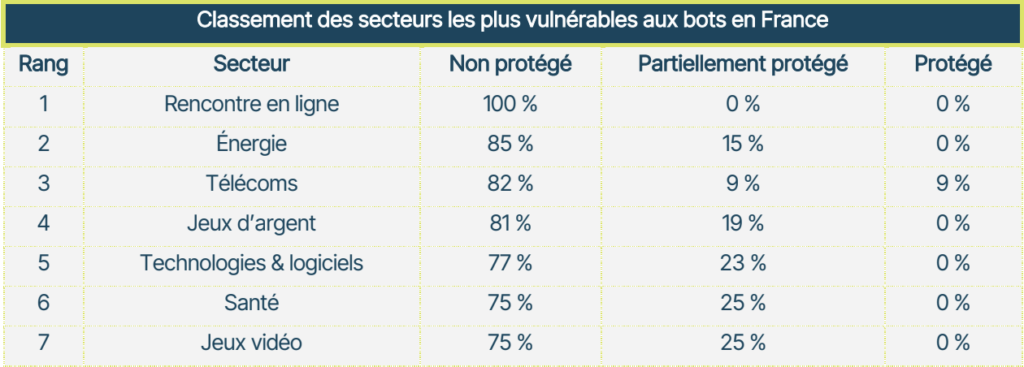

Retour sur les principales conclusions de l’étude en France

- Il y a une véritable croissance des menaces années après années : la France n’échappe pas aux grandes tendances révélées par le rapport, en effet, le trafic des robots est de plus en plus difficile à distinguer du comportement humain, et la situation devient encore plus complexe à mesure que les utilisateurs légitimes commencent à s’appuyer sur des agents d’IA pour parcourir, comparer et finaliser leurs transactions. DataDome bloque désormais plus de 400 milliards d’attaques de bots par an, soit une augmentation de 14 % par rapport à l’année précédente.

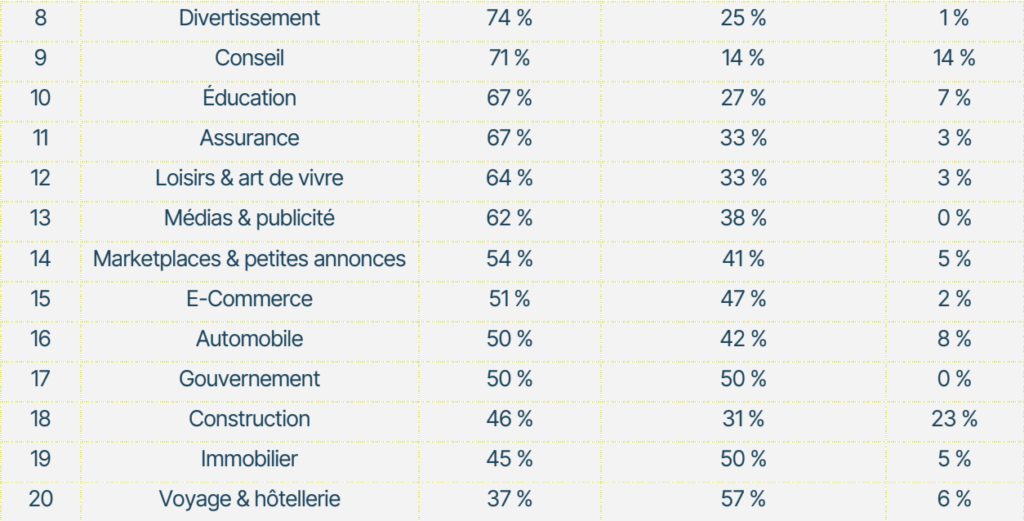

- En France, selon les secteurs d’activités, quel est le niveau de protection atteint ?

– La santé est le secteur analysé le moins bien protégé : 3 sites web sur 4 ne sont pas protégés, et aucun n’est totalement protégé.

– Le secteur des jeux vidéo présente un important déficit de protection : en effet, bien qu’il s’agisse d’un secteur à haut risque de fraude et d’abus, aucun des sites analysés n’est totalement protégé.

– Le secteur du bâtiment est à l’heure actuelle le secteur le plus protégé, avec 23 % des sites testés totalement protégés.

– Les secteurs du voyage et de l’hôtellerie ne sont pas en reste : avec plus de 60 % des sites qui bénéficient d’une protection minimale, dont près de 6 % sont entièrement protégés.

- Parmi les sites web français, qui sont les mieux protégés compte tenu de leur trafic ?

– Parmi les sites web, ceux avec plus de 30 millions de vues mensuelles sont les moins bien protégés, avec seulement 2,86 % bénéficiant d’une excellente protection. Les sites français avec 20 millions de vues par page sont les mieux protégés (4 %).

« Aujourd’hui, il ne s’agit plus seulement de lutter contre la fraude en ligne, mais de faire en sorte que les entreprises puissent répondre à ce double défi : ne pas passer à côté des opportunités sur leur site à cause du trafic généré par l’IA, tout en arrivant à se défendre contre les menaces sophistiquées. La sécurité doit impérativement évoluer à la vitesse de l’IA. », conclut Jérôme Segura, vice-président de la recherche chez DataDome.

Ce rapport confirme que l’IA est en train de transformer durablement la structure d’Internet. Les sites web ne se contentent plus d’opposer humains et robots ; ils sont confrontés à un spectre d’activités d’IA mêlant automatisation et intervention humaine, rendant les outils traditionnels de moins en moins efficaces et remettant en cause les stratégies de défenses actuelles.